重塑芯片设计未来:Synopsys.ai Copilot,以生成式AI解锁无限创新

在半导体行业追逐更高性能、更低功耗和更短上市时间的竞赛中,设计复杂度已逼近传统方法的极限。工程师们常常需要在上亿甚至数十亿个晶体管构成的迷宫中,寻找最优的布局、布线和验证方案,这一过程不仅耗时数月,更高度依赖稀缺的顶尖专家经验。

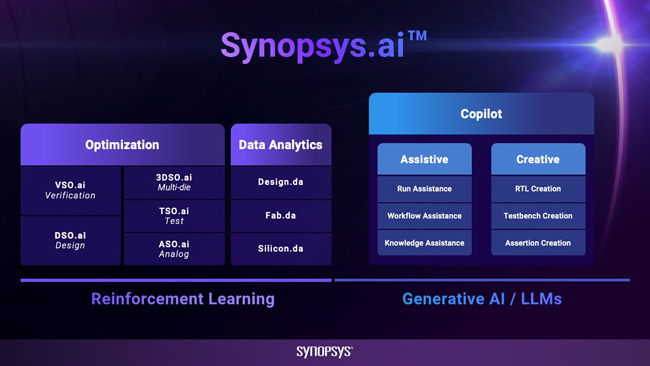

如今,一场由人工智能驱动的范式革命正在发生。新思科技(Synopsys)推出的Synopsys.ai Copilot,作为业界首个贯穿芯片设计全栈的生成AI技术,正将这项挑战转化为机遇。它不仅仅是一个工具,更是一位内置于设计环境中的“AI设计专家”,从根本上改变了工程师的工作模式,让创新得以以前所未有的速度实现。

一、AI功能特点:从辅助到创造的智能跃迁

Synopsys.ai Copilot的核心在于其三大AI能力支柱,它们共同构成了一个从知识获取、流程自动化到创造性工作的完整智能闭环。

-

知识助手:随身的虚拟专家

这是一个强大的上下文感知问答引擎。它能理解工程师当前的设计任务和挑战,提供关于工具使用、设计流程和方法学的即时专家级指导。工程师无需离开工作环境、手动搜索浩瀚文档,即可获得精准答案,将信息检索效率提升40%,极大加速了问题决策过程。 -

工作流助手:零代码的自动化大师

该功能深度简化了EDA环境中最为复杂和易错的脚本编写与优化工作。通过直观的自然语言交互或图形化引导,AI能帮助工程师自动配置、优化工作流脚本,实现流程自动化。它提供上下文感知建议,确保脚本高效且符合项目规范,从而显著减少手动编码错误,提升整体工程效率。 -

创意生成式AI:核心设计的智能伙伴

这是Copilot从“辅助”迈向“创造”的关键。它能够基于设计意图和约束,自动生成高质量的设计内容,目前已支持RTL代码和形式验证断言的生成。这意味着AI可以直接参与核心知识产权(IP)的创建与验证准备,帮助团队快速探索更多设计替代方案,加速从概念到实现的过程。

二、核心应用场景:赋能全栈设计流程

这些AI能力已无缝融入芯片设计的多个关键场景,解决实际痛点:

- 新手培训与团队效率提升:知识助手让新工程师能快速上手复杂的Synopsys工具链,缩短学习曲线。同时,它作为统一的“知识库”,提升了团队整体决策水平和协作一致性。

- 设计实现与验证自动化:在数字后端,工作流助手可自动化完成物理实现、时序分析等流程的脚本编写。在验证前端,创意生成式AI能自动生成测试场景和形式断言,将工程师从繁重、重复的编写工作中解放出来,专注于更复杂的验证策略。

- 设计探索与创新加速:面对严苛的性能、功耗和面积(PPA)目标,创意生成式AI可以快速分析现有设计,提出多种优化方案供工程师评估。这种“AI驱动探索”模式,能够发现人工可能忽略的潜在优化点,将达成最优解决方案的时间缩短10至20倍。

三、主要算法与计算特点

支撑Synopsys.ai Copilot智能的,是前沿的生成式人工智能模型与算法,其计算特点鲜明:

算法核心:

- 大型语言模型:知识助手和自然语言交互的核心基于经过海量技术文档、代码和设计数据专项训练的LLM。它不仅能理解通用语言,更能精准解析芯片设计领域的专业术语、工具命令和设计规范。

- 代码生成与序列建模:用于RTL和脚本生成的AI,本质上是经过代码、硬件描述语言和EDA脚本语料训练的代码生成模型。它将设计约束(如时序、面积)转化为符合语法和功能要求的代码序列。

- 强化学习与优化算法:在设计探索和优化建议中,系统可能采用结合了强化学习的算法,通过模拟不同的设计调整并评估其PPA结果,来学习并推荐最优的改进路径。

计算特点:

- 混合计算模式:用户端的交互(如问答、建议)依赖云端或本地高性能服务器的模型推理,要求低延迟以保持交互流畅。而模型的训练和迭代则是在后台数据中心进行的大规模、周期性的高强度并行计算。

- 上下文窗口与记忆:为了提供精准的上下文感知帮助,模型需要处理并“记住”当前工程设计会话的长上下文信息,这对算法的记忆能力和计算效率提出了很高要求。

- 数据驱动与持续学习:系统的有效性建立在持续吸收匿名化的项目数据、设计模式和最佳实践之上。这是一个数据驱动的闭环,AI在应用中学习,其推荐能力也随之不断进化。

四、硬件配置推荐:为AI设计引擎提供强劲动力

要流畅运行并最大化发挥Synopsys.ai Copilot的效能,尤其是处理大规模设计项目时,需要均衡且强大的硬件支持。

以下是针对专业设计工作站和数据中心部署的配置建议:

4.1本地工作站 (工程师端)

用于日常交互、中小规模设计任务和本地推理。

|

组件分类 |

推荐配置 |

说明与理由 |

|

处理器(CPU) |

英特尔® 至强® W9 或 AMD 锐龙™ Threadripper PRO 系列(16核心/32线程以上) |

高主频保障EDA工具流畅运行,多核心应对并行验证任务。大缓存有益于处理大型设计数据。 |

|

内存(RAM) |

128GB DDR5 ECC 起步,复杂设计建议 256GB 或更高 |

确保超大型芯片设计数据库和AI模型上下文能完全载入内存,避免因与硬盘交换数据导致的卡顿。 |

|

图形卡(GPU) |

NVIDIA RTX 6000 Ada 或更高规格专业卡(显存48GB起步) |

大显存对处理数亿门级设计的图形渲染至关重要,并为可能的本地AI推理提供强力加速。 |

|

系统存储 |

2TB NVMe PCIe 5.0 SSD |

极快的读写速度(超过10 GB/s)能瞬间加载操作系统、软件和庞大的项目文件。 |

4.2企业级服务器/数据中心 (AI服务端)

用于部署Copilot服务、运行重型AI模型训练与推理。

|

组件分类 |

推荐配置 |

说明与理由 |

|

计算节点 |

多台配备NVIDIA H100 或 GH200 Grace Hopper超级芯片的服务器 |

专为AI计算设计的GPU和芯片,提供FP8/TF32等精度下的极致浮点算力和高速互联,是训练和高效推理的基石。 |

|

内存与存储 |

每节点TB级DDR5/HBM内存+全闪存存储阵列 |

海量内存支撑大模型,全闪存阵列确保千名工程师并发访问时的数据吞吐与低延迟。 |

|

网络 |

InfiniBand NDR 400G 或更高 |

超高带宽、超低延迟的网络对于多GPU服务器节点间同步训练、参数更新不可或缺。 |

重要提示:以上为基于高性能AI辅助设计场景的通用推荐。对于具体部署,尤其是数据中心层面的架构设计,强烈建议直接咨询新思科技(Synopsys)官方技术支持。他们能根据企业的实际设计规模、用户并发数和IT基础设施,提供经过验证的最优配置方案。

结语:与AI协同,定义下一代的芯片

Synopsys.ai Copilot 的出现,标志着芯片设计从一门高度依赖个人经验与手动迭代的“技艺”,正式进化为一个融合人类智慧与机器智能的“科学”。它解除了工程师在信息搜寻和重复编码上的束缚,赋予他们更强的探索能力和创新自由。

未来,随着AI模型的持续进化与学习,它所能参与的环节将更加深入,从系统架构到制造工艺协同,最终实现全流程的自主优化。在这个由AI重新定义的竞争格局中,率先拥抱并善用这一强大协作者的企业,将掌握解锁下一代芯片创新的密钥,引领整个半导体行业迈向智能设计的新纪元。

我们专注于行业计算应用,并拥有20年以上丰富经验,

通过分析软件计算特点,给出专业匹配的工作站硬件配置方案,

系统优化+低延迟响应+加速技术(超频技术、虚拟并行计算、超频集群技术、闪存阵列等),

多用户云计算(内网穿透)

保证最短时间完成计算,机器使用率最大化,事半功倍。

上述所有配置,代表最新硬件架构,同时保证是最完美,最快,如有不符,可直接退货

欲咨询机器处理速度如何、技术咨询、索取详细技术方案,提供远程测试,请联系

咨询微信号:100369800

UltraLAB图形工作站供货商:

西安坤隆计算机科技有限公司

国内知名高端定制图形工作站厂家

业务电话:400-705-6800